---

comments: true

---

# 文本识别模块使用教程

## 一、概述

文本识别模块是OCR(光学字符识别)系统中的核心部分,负责从图像中的文本区域提取出文本信息。该模块的性能直接影响到整个OCR系统的准确性和效率。文本识别模块通常接收文本检测模块输出的文本区域的边界框(Bounding Boxes)作为输入,然后通过复杂的图像处理和深度学习算法,将图像中的文本转化为可编辑和可搜索的电子文本。文本识别结果的准确性,对于后续的信息提取和数据挖掘等应用至关重要。

## 二、支持模型列表

| 模型 | 模型下载链接 |

识别 Avg Accuracy(%) |

GPU推理耗时(ms) |

CPU推理耗时 (ms) |

模型存储大小(M) |

介绍 |

| PP-OCRv4_mobile_rec | 推理模型/训练模型 |

78.20 |

7.95018 |

46.7868 |

10.6 M |

PP-OCRv4是百度飞桨视觉团队自研的文本识别模型PP-OCRv3的下一个版本,通过引入数据增强方案、GTC-NRTR指导分支等策略,在模型推理速度不变的情况下,进一步提升了文本识别精度。该模型提供了服务端(server)和移动端(mobile)两个不同版本,来满足不同场景下的工业需求。 |

| PP-OCRv4_server_rec | 推理模型/训练模型 |

79.20 |

7.19439 |

140.179 |

71.2 M |

注:以上精度指标的评估集是 PaddleOCR 自建的中文数据集,覆盖街景、网图、文档、手写多个场景,其中文本识别包含 1.1w 张图片。所有模型 GPU 推理耗时基于 NVIDIA Tesla T4 机器,精度类型为 FP32, CPU 推理速度基于 Intel(R) Xeon(R) Gold 5117 CPU @ 2.00GHz,线程数为8,精度类型为 FP32。

> ❗ 以上列出的是目标检测模块重点支持的2个核心模型,该模块总共支持4个模型,完整的模型列表如下:

👉模型列表详情

| 模型 | 模型下载链接 |

识别 Avg Accuracy(%) |

GPU推理耗时(ms) |

CPU推理耗时 (ms) |

模型存储大小(M) |

介绍 |

| PP-OCRv4_mobile_rec | 推理模型/训练模型 |

78.20 |

7.95018 |

46.7868 |

10.6 M |

PP-OCRv4是百度飞桨视觉团队自研的文本识别模型PP-OCRv3的下一个版本,通过引入数据增强方案、GTC-NRTR指导分支等策略,在模型推理速度不变的情况下,进一步提升了文本识别精度。该模型提供了服务端(server)和移动端(mobile)两个不同版本,来满足不同场景下的工业需求。 |

| PP-OCRv4_server_rec | 推理模型/训练模型 |

79.20 |

7.19439 |

140.179 |

71.2 M |

注:以上精度指标的评估集是 PaddleOCR 自建的中文数据集,覆盖街景、网图、文档、手写多个场景,其中文本识别包含 1.1w 张图片。所有模型 GPU 推理耗时基于 NVIDIA Tesla T4 机器,精度类型为 FP32, CPU 推理速度基于 Intel(R) Xeon(R) Gold 5117 CPU @ 2.00GHz,线程数为8,精度类型为 FP32。

| 模型 | 模型下载链接 |

识别 Avg Accuracy(%) |

GPU推理耗时(ms) |

CPU推理耗时 |

模型存储大小(M) |

介绍 |

| ch_SVTRv2_rec | 推理模型/训练模型 |

68.81 |

8.36801 |

165.706 |

73.9 M |

SVTRv2 是一种由复旦大学视觉与学习实验室(FVL)的OpenOCR团队研发的服务端文本识别模型,其在PaddleOCR算法模型挑战赛 - 赛题一:OCR端到端识别任务中荣获一等奖,A榜端到端识别精度相比PP-OCRv4提升6%。

|

注:以上精度指标的评估集是 PaddleOCR算法模型挑战赛 - 赛题一:OCR端到端识别任务A榜。 所有模型 GPU 推理耗时基于 NVIDIA Tesla T4 机器,精度类型为 FP32, CPU 推理速度基于 Intel(R) Xeon(R) Gold 5117 CPU @ 2.00GHz,线程数为8,精度类型为 FP32。

| 模型 | 模型下载链接 |

识别 Avg Accuracy(%) |

GPU推理耗时(ms) |

CPU推理耗时 |

模型存储大小(M) |

介绍 |

| ch_RepSVTR_rec | 推理模型/训练模型 |

65.07 |

10.5047 |

51.5647 |

22.1 M |

RepSVTR 文本识别模型是一种基于SVTRv2 的移动端文本识别模型,其在PaddleOCR算法模型挑战赛 - 赛题一:OCR端到端识别任务中荣获一等奖,B榜端到端识别精度相比PP-OCRv4提升2.5%,推理速度持平。 |

注:以上精度指标的评估集是 PaddleOCR算法模型挑战赛 - 赛题一:OCR端到端识别任务B榜。 所有模型 GPU 推理耗时基于 NVIDIA Tesla T4 机器,精度类型为 FP32, CPU 推理速度基于 Intel(R) Xeon(R) Gold 5117 CPU @ 2.00GHz,线程数为8,精度类型为 FP32。

👉 校验结果详情(点击展开)

校验结果文件具体内容为:

{

"done_flag": true,

"check_pass": true,

"attributes": {

"train_samples": 4468,

"train_sample_paths": [

"../dataset/ocr_rec_dataset_examples/images/train_word_1.png",

"../dataset/ocr_rec_dataset_examples/images/train_word_10.png"

],

"val_samples": 2077,

"val_sample_paths": [

"../dataset/ocr_rec_dataset_examples/images/val_word_1.png",

"../dataset/ocr_rec_dataset_examples/images/val_word_10.png"

]

},

"analysis": {

"histogram": "check_dataset/histogram.png"

},

"dataset_path": "./dataset/ocr_rec_dataset_examples",

"show_type": "image",

"dataset_type": "MSTextRecDataset"

}

上述校验结果中,check_pass 为 true 表示数据集格式符合要求,其他部分指标的说明如下:

attributes.train_samples:该数据集训练集样本数量为 4468;attributes.val_samples:该数据集验证集样本数量为 2077;attributes.train_sample_paths:该数据集训练集样本可视化图片相对路径列表;attributes.val_sample_paths:该数据集验证集样本可视化图片相对路径列表;

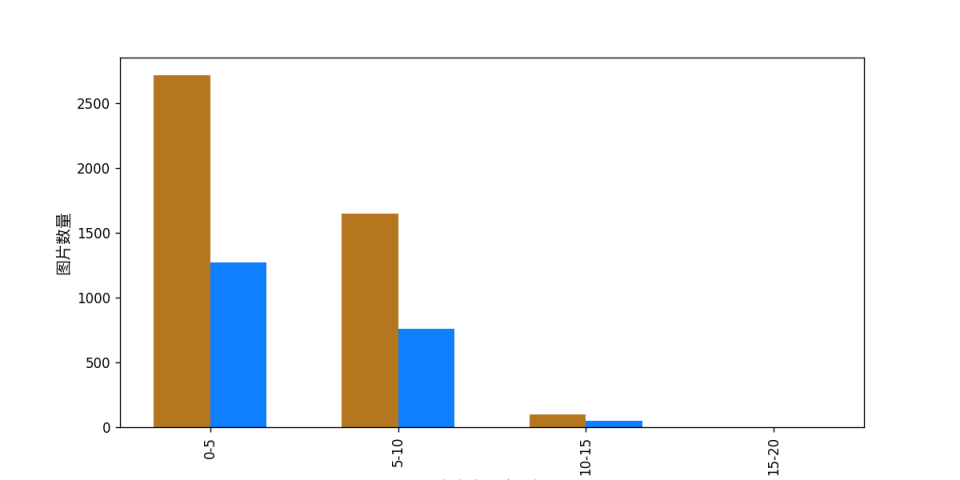

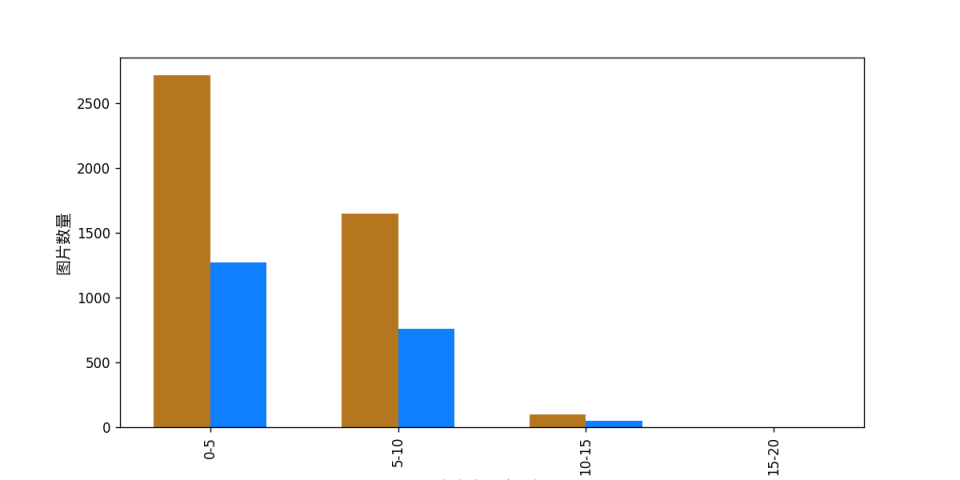

另外,数据集校验还对数据集中所有字符长度占比的分布情况进行了分析,并绘制了分布直方图(histogram.png):

👉 格式转换/数据集划分详情(点击展开)

(1)数据集格式转换

文本识别暂不支持数据转换。

(2)数据集划分

数据集划分的参数可以通过修改配置文件中 CheckDataset 下的字段进行设置,配置文件中部分参数的示例说明如下:

CheckDataset:split:enable: 是否进行重新划分数据集,为 True 时进行数据集格式转换,默认为 False;train_percent: 如果重新划分数据集,则需要设置训练集的百分比,类型为0-100之间的任意整数,需要保证和 val_percent 值加和为100;

例如,您想重新划分数据集为 训练集占比90%、验证集占比10%,则需将配置文件修改为:

......

CheckDataset:

......

split:

enable: True

train_percent: 90

val_percent: 10

......

随后执行命令:

python main.py -c paddlex/configs/text_recognition/PP-OCRv4_mobile_rec.yaml \

-o Global.mode=check_dataset \

-o Global.dataset_dir=./dataset/ocr_rec_dataset_examples

数据划分执行之后,原有标注文件会被在原路径下重命名为 xxx.bak。

以上参数同样支持通过追加命令行参数的方式进行设置:

python main.py -c paddlex/configs/text_recognition/PP-OCRv4_mobile_rec.yaml \

-o Global.mode=check_dataset \

-o Global.dataset_dir=./dataset/ocr_rec_dataset_examples \

-o CheckDataset.split.enable=True \

-o CheckDataset.split.train_percent=90 \

-o CheckDataset.split.val_percent=10

👉 更多说明(点击展开)

👉 更多说明(点击展开)

在模型评估时,需要指定模型权重文件路径,每个配置文件中都内置了默认的权重保存路径,如需要改变,只需要通过追加命令行参数的形式进行设置即可,如-o Evaluate.weight_path=./output/best_accuracy/best_accuracy.pdparams。

在完成模型评估后,通常有以下产出:evaluate_result.json,其记录了评估的结果,具体来说,记录了评估任务是否正常完成,以及模型的评估指标,包含 acc、norm_edit_dis;